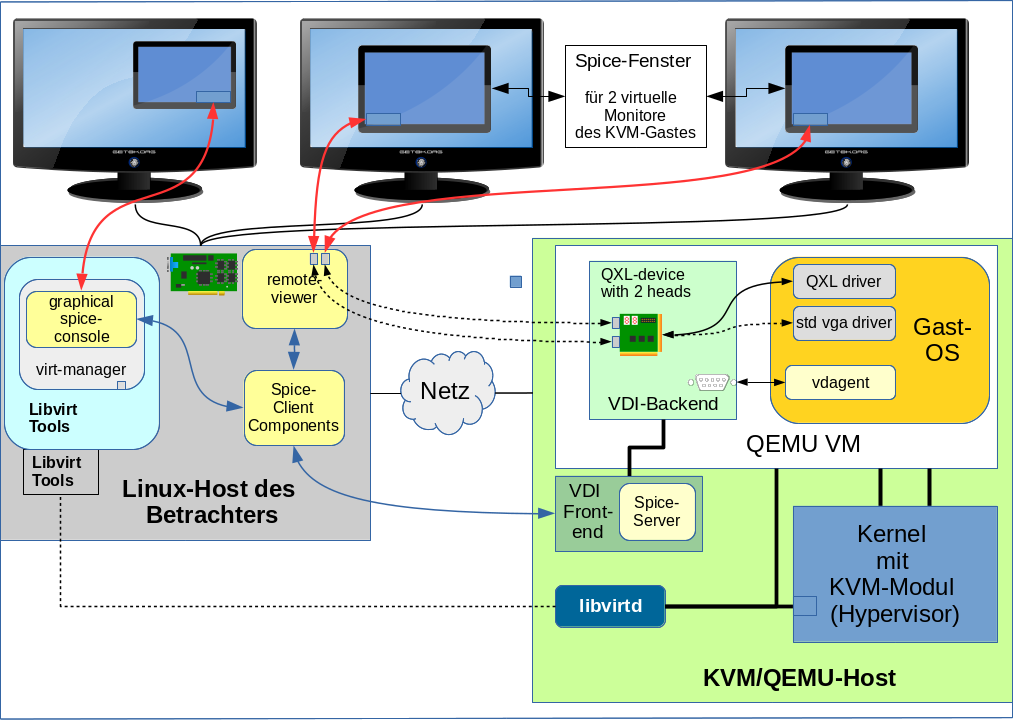

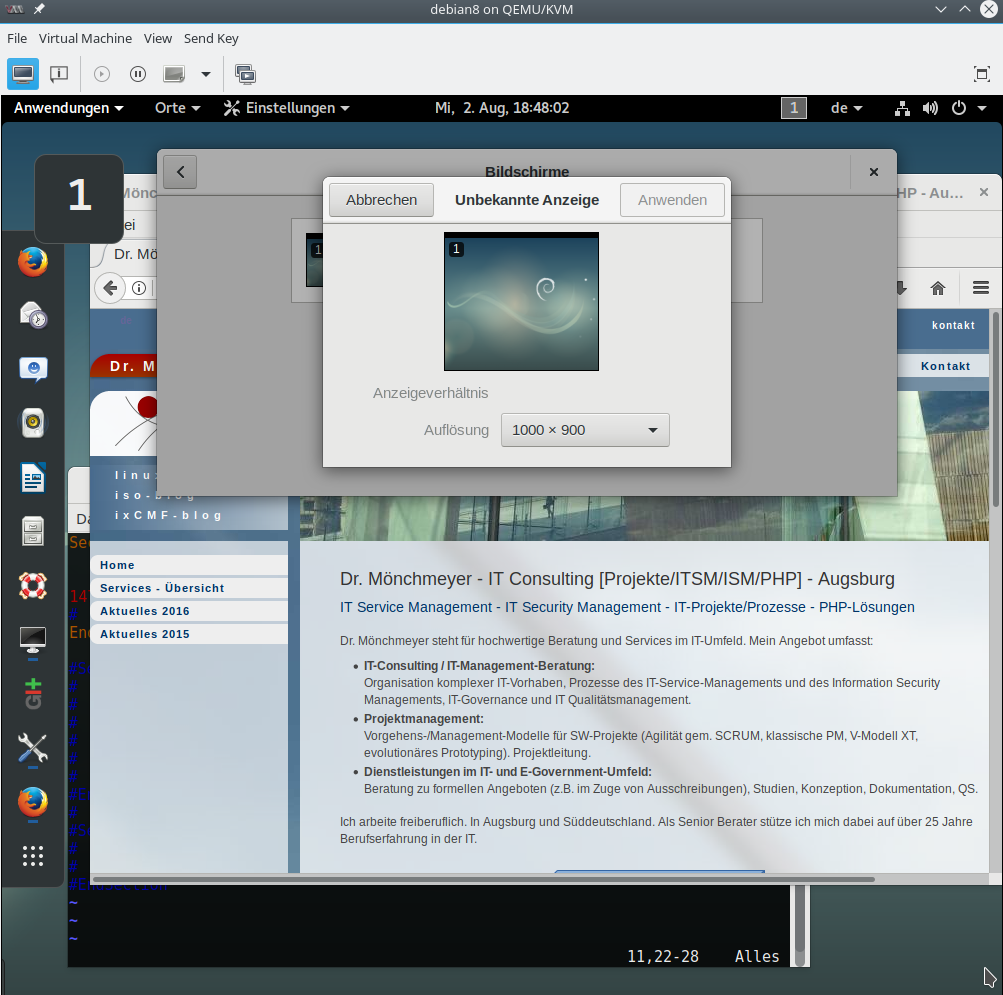

Ich betreibe bestimmte Linux-Systeme als KVM-Gäste mit verschlüsseltem Plattenunterbau. Die Partitionen des KVM-Hosts selbst sind zwar auch verschlüsselt; in diesem Artikel betrachte ich aber verschlüsselte virtuelle Disks für KVM-Gastsysteme. Ich nutze hierfür auf dem KVM-Host definierte LVM-Volumes, die mit dm-crypt/LUKS verschlüsselt wurden.

Dabei setze ich regelmäßig zwei Varianten ein:

- Variante 1: Ein oder mehrere verschlüsselte LVM-Volumes werden dem Gastsystem (in entschlüsseltem Zustand) als “Raw-Devices” zur Verfügung gestellt. Das Gastsystem erstellt dort seine Partitionen (oder im Einzelfall auch eigene LVM-Volumes) mit je einem Linux-Filesystem.

- Variante 2: Verschlüsselte LVM-Volumes des Hosts enthalten qcow2-Container-Dateien, die vom KVM-Gast als virtuelle Disks genutzt werden. Im qcow2-Container legt der Gast dann eigene LVM-Volumes mit einem Linux-Filesystem an.

Für regelmäßige fsck-Checks der Filesysteme im KVM-Gast kann man einerseits dadurch sorgen, dass man entsprechende Einstellungen für das Gast-Filesystem selbst vornimmt. So kann man mit “tune2fs” den sog. “maximum mount count” auf eine hinreichend kleine Anzahl von Mounts stellen. Das empfiehlt sich vor allem beim root-Filesystem des Gastes: Das darf ja bei der Durchführung von fsck nicht gemountet sein – dies erfordert ansonsten Kunstgriffe, wenn man im bootenden KVM-Gast vor dem Mounten des root-Filesystems fsck erzwingen will.

Manchmal möchte man im Rahmen automatisierter Maintenance-Verfahren aber auch direkt vom KVM-Host aus Filesystem-Checks mit fsck für die Filesystem der KVM-Gäste durchführen. Natürlich ohne das Gastsystem hochzufahren. Wie macht man das im Fall der genannten zwei Varianten?

fsck in Variante 1 – LVM-Volume als verschlüsseltes Raw-Device des Gastes

Variante 1 weist folgende Schichtung bzgl. der physikalischen und virtuellen Disks auf:

- Physikalische Plattenpartitionen für Raid >>

- Raid 10 >>

- LVM >>

- LVM-Groups und LVM-Volumes, die der Host nutzen kann >>

- dm-crypt/LUKS-Verschlüsselung eines (oder mehrerer) von LVM-Volumes, die den Gästen as Raw-Devices bereitgestellt werden. >>

- KVM/QEMU- und Gastsystem mit Zugriff auf das Raw-Volume als virtuelle Platte >>

- Partitionen (oder LVM-Volumes) im Gastsystem >>

- ext4-Filesysteme im Gastsystem

Hier führt der Weg über die Anwendung von “cryptsetup” und z.B. das Tool “kpartx” (das man natürlich installiert haben muss). Wir führen alle Operation natürlich nur dann durch, wenn das KVM-Gastsystem selbst nicht läuft. Wir müssen vermeiden, dass auf die Partitionen des Gastes von mehreren Betriebssystemen aus (Host und Gast) gleichzeitig schreibend zugegriffen wird.

Ich gehe in unserem Beispiel mal davon aus, dass die Entschlüsselung des betreffenden LVM-Volumes für den Gast auf dem KVM-Host noch nicht vorgenommen wurde. Dieses Volume liege in einer logischen Volume Group “lvg2” und habe die Bezeichnung “lvhd0”.

Das Kommando “la” ist in folgendem Beispiel ein Alias für ‘ls -la’; alle Kommandos werden direkt auf dem Host ausgeführt. Das jeweilige KVM-Gastsystem ist nicht hochgefahren. Unter dem Verzeichnis “/dev/mapper” finden wir dann bei aktivierten Volume-Groups auf dem KVM-Host etwa

folgenden Eintrag vor;

mytux:~ # la /dev/mapper total 0 drwxr-xr-x 2 root root 340 Aug 4 09:46 . drwxr-xr-x 22 root root 9720 Aug 4 09:50 .. crw------- 1 root root 10, 236 Aug 4 09:41 control ... lrwxrwxrwx 1 root root 8 Aug 4 09:46 lvg2-lvhd0 -> ../dm-11 ...

Zunächst müssen wir dieses Volume entschlüsseln:

mytux:~ # cryptsetup open /dev/mapper/lvg2-lvhd0 cr_hd0 Enter passphrase for /dev/mapper/lvg2-lvhd0: mytux:~ # la /dev/mapper total 0 drwxr-xr-x 2 root root 340 Aug 4 09:46 . drwxr-xr-x 22 root root 9720 Aug 4 09:50 .. crw------- 1 root root 10, 236 Aug 4 09:41 control lrwxrwxrwx 1 root root 8 Aug 4 09:46 cr_hd0 -> ../dm-16 ... lrwxrwxrwx 1 root root 8 Aug 4 09:46 lvg2-lvhd0 -> ../dm-11 ...

Ok. Der Befehl “qemu-img” informiert uns darüber, dass wir es tatsächlich mit einem Raw-Device (von 100GB Größe) zu tun haben:

mytux:~ # qemu-img info /dev/mapper/cr_hd0 image: /dev/mapper/cr_hd0 file format: raw virtual size: 100G (107372085248 bytes) disk size: 0

Infos zur Partitionierung des “Raw Devices”

In unserem Beispiel befinden sich auf dem entschlüsselten LVM-Volume des Hosts zwei Partitionen des Gastes: eine swap-Partition und eine Partition mit einem ext4-Filesystem. Es gibt mehrere Tools, mit denen man die Partitionsstruktur unterhalb eines Raw-Devices für einen KVM-Gast auf dem Host selbst untersuchen kann:

“fdisk”, “parted”, “virt-filesystems” und eben auch “kpartx”:

mytux:~ # fdisk -l /dev/mapper/cr_hd0 Disk /dev/mapper/cr_imap: 100 GiB, 107372085248 bytes, 209711104 sectors Units: sectors of 1 * 512 = 512 bytes Sector size (logical/physical): 512 bytes / 512 bytes I/O size (minimum/optimal): 512 bytes / 512 bytes Disklabel type: dos Disk identifier: 0x00041fe1 Device Boot Start End Sectors Size Id Type /dev/mapper/cr_hd0-part1 2048 3067903 3065856 1.5G 82 Linux swap / Solaris /dev/mapper/cr_hd0-part2 * 3067904 167772159 164704256 78.6G 83 Linux mytux:~ # parted /dev/mapper/cr_hd0 unit s print Model: Linux device-mapper (crypt) (dm) Disk /dev/mapper/cr_hd0: 209711104s Sector size (logical/physical): 512B/512B Partition Table: msdos Disk Flags: Number Start End Size Type File system Flags 1 2048s 3067903s 3065856s primary linux-swap(v1) type=82 2 3067904s 167772159s 164704256s primary ext4 boot, type=83

mytux:~ # virt-filesystems -a /dev/mapper/cr_hd0 --extra /dev/sda1 /dev/sda2 mytux:~ # virt-filesystems -a /dev/mapper/cr_hd0 --extra -l Name Type VFS Label Size Parent /dev/sda1 filesystem swap - 1569718272 - /dev/sda2 filesystem ext4 - 84328579072 -

mytux:~ # kpartx -l /dev/mapper/cr_hd0 cr_hd01 : 0 3065856 /dev/mapper/cr_hd0 2048 cr_hd02 : 0 164704256 /dev/mapper/cr_hd0 3067904

Hinweis:

kpartx liefert Infos zur Partionierung (samt Offests) auch für Disk-Image-Files im “Raw”-Format. kpartx funktioniert jedoch nicht für Disk-Image-Files im qcow2-Format!

Mit Ausnahme von “virt-filesystems” stellen uns alle oben vorgestellten Tools auch Offset-Informationen zur Verfügung:

Die Angaben 2048(s) und 3067904(s) entsprechen Offset-Adressen der Partitionen; wir müssen die Zahl

der Sektoren allerdings noch mit der Anzahl der Bytes (512) multiplizieren: also z.B. 2048 * 512 ist der Offset für die erste (swap-) Partition.

Man könnte zur Partitionsbestimmmung auch “guestfish” und die zu guestfish gehörigen Sub-Kommandos run und list-filesystems oder aber auch das Tool “qemu-nbd” heranziehen. “qemu-nbd” diskutiere ich gleich im Detail anhand der Variante 2.

Partitionen des Raw-LVM-Volumes (= Raw-Device für das KVM-Gastsytem )ansprechen

“kpartx -a” liefert uns für Devices im Raw-Format eine einfache Möglichkeit, die darin liegenden Partitionen anzusprechen.

mytux:~ # kpartx -a /dev/mapper/cr_hd0 mytux:~ # la /dev/mapper total 0 drwxr-xr-x 2 root root 420 Aug 6 14:36 . drwxr-xr-x 22 root root 9740 Aug 6 14:36 .. crw------- 1 root root 10, 236 Aug 6 08:26 control lrwxrwxrwx 1 root root 8 Aug 6 14:32 cr_hd0 -> ../dm-16 lrwxrwxrwx 1 root root 8 Aug 6 14:36 cr_hd01 -> ../dm-17 lrwxrwxrwx 1 root root 8 Aug 6 14:36 cr_hd02 -> ../dm-18 lrwxrwxrwx 1 root root 8 Aug 6 14:36 cr_hd0_part1 -> ../dm-17 lrwxrwxrwx 1 root root 8 Aug 6 14:36 cr_hd0_part2 -> ../dm-18 .... lrwxrwxrwx 1 root root 7 Aug 6 08:55 lvg2-lvhd0 -> ../dm-11 ... mytux:~ #

Man beachte die unterschiedliche Bezeichnung, die auf das gleiche Device verlinken. Wir wissen bereits, dass die zweite Partition ein ext4-Filesystem des KVM-Gastes enthält. Also

mytux:~ # fsck -f /dev/mapper/cr_hd02 fsck from util-linux 2.29.2 e2fsck 1.42.11 (09-Jul-2014) Pass 1: Checking inodes, blocks, and sizes Pass 2: Checking directory structure Pass 3: Checking directory connectivity Pass 4: Checking reference counts Pass 5: Checking group summary information /dev/mapper/cr_hd02: 1016912/5152768 files (0.1% non-contiguous), 6724050/20588032 blocks mytux:~ #

Anschließend können wir das Mapping durch “kpartx -d” wieder rückgängig machen:

mytux:~ # kpartx -d /dev/mapper/cr_hd0 mytux:~ # la /dev/mapper total 0 drwxr-xr-x 2 root root 340 Aug 6 14:45 . drwxr-xr-x 22 root root 9700 Aug 6 14:45 .. crw------- 1 root root 10, 236 Aug 6 08:26 control lrwxrwxrwx 1 root root 8 Aug 6 14:32 cr_hd0 -> ../dm-16 ... lrwxrwxrwx 1 root root 7 Aug 6 08:55 lvg2-lvhd0 -> ../dm-11 mytux:~ #

Was tun, wenn das Gastsystem auch selbst LVM nutzt?

In unserem Fall lag im Gastsystem selbst keine LVM-Struktur vor. Hätten wir das gehabt, hätten wir noch zwei weitere Schritte vornehmen müssen – nämlich “vgscan”, “vgchange -ay”. Erst danach hätten wir “fsck” ausführen können. Wir werden dies weiter unten bei der Diskussion der Variante 2 sehen.

Arbeit über Loop-Devices

Der Vollständigkeit halber zeige ich kurz noch, wie man Partitionen von KVM-RAW-Devices über ihre Offsets auch als Loop-Devices ansprechen kann. Die zweite Partition hat in unserem Beispiel einen Offset von 3067904 * 512 = 1570766848 Bytes.

Also:

mytux:~ # losetup -r -o 1570766848 /dev/loop3 /dev/mapper/cr_hd0 mytux:~ # fsck -f /dev/loop3 fsck from util-linux 2.29.2 e2fsck 1.42.11 (09-Jul-2014) fsck.ext4: Operation not permitted while trying to open /dev/loop3 You must have r/w access to the filesystem or be root mytux:~ # losetup -d /dev/loop3 mytux:~ # losetup -o 1570766848 /dev/loop3 /dev/mapper/cr_hd0 mytux:~ # fsck -f /dev/loop3 fsck from util-linux 2.29.2 e2fsck 1.42.11 (09-Jul-2014) Pass 1: Checking inodes, blocks, and sizes Pass 2: Checking directory structure Pass 3: Checking directory connectivity Pass 4: Checking reference counts Pass 5: Checking group summary information /dev/loop3: 1016912/5152768 files (0.1% non-contiguous), 6724050/20588032 blocks mytux:~ # mytux:~ # tune2fs -l /dev/loop3 tune2fs 1.42.11 (09-Jul-2014) Filesystem volume name: <none> Last mounted on: / Filesystem UUID: 4388dd4b-ac1a-5c9c-b8d6-88e53b12bd2d Filesystem magic number: 0xEF53 Filesystem revision #: 1 (dynamic) Filesystem features: has_journal ext_attr resize_inode dir_index filetype extent flex_bg sparse_super large_file huge_file uninit_bg dir_nlink extra_isize Filesystem flags: signed_directory_hash Default mount options: user_xattr acl Filesystem state: clean Errors behavior: Continue Filesystem OS type: Linux Inode count: 5152768 Block count: 20588032 Reserved block count: 267644 Free blocks: 13863982 Free inodes: 4135856 First block: 0 Block size: 4096 Fragment size: 4096 Reserved GDT blocks: 1019 Blocks per group: 32768 Fragments per group: 32768 Inodes per group: 8192 Inode blocks per group: 512 Flex block group size: 16 Filesystem created: Mon Jan 6 15:44:37 2014 Last mount time: Mon Aug 6 08:56:27 2018 Last write time: Mon Aug 6 15:01:58 2018 Mount count: 0 Maximum mount count: 2 Last checked: Mon Aug 6 15:01:58 2018 Check interval: 172800 (2 days) Next check after: Wed Aug 8 15:01:58 2018 Lifetime writes: 2270 GB Reserved blocks uid: 0 (user root) Reserved blocks gid: 0 (group root) First inode: 11 Inode size: 256 Required extra isize: 28 Desired extra isize: 28 Journal inode: 8 Default directory hash: half_md4 Directory Hash Seed: ce2daf83-bc25-44d5-fcdf-b35afd5c8f2b Journal backup: inode blocks mytux:~ # mytux:~ # losetup -d /dev/loop3

Der Leser sieht, dass ich in der letzten Befehlssequenz anfänglich aus lauter guter Gewohnheit das Device nur im read-only modus als Loop-Device angelegt hatte. Erst nach einer Korrektur läuft dann fsck. Natürlich kann man dann z.B. auch tune2fs auf das Loop-Device anwenden. Über Loop-Devices geht es also auch. Man muss dann halt nur die Offsets wissen!

fsck in Variante 2 – verschlüsseltes LVM-Volume mit Disk-Image-File im “qcow2”-Format

In diesem Szenario liegt eine wirklich komplexe Schichtung vor:

KVM-Host -> LVM-Volume-Group -> Luks-verschlüsseltes LVM-Volume -> qcow2-Image-File -> Partitions- und LVM-Struktur des KVM-Gastsystems -> Volumegroup mit LVM-Volume des Gastes -> ext4-Filesystem

In diesem Szenario wirken sich vor allem zwei bedeutsame Unterschiede zur Variante 1 aus:

- Unser Disk-Image-File (eine Art Container-File; “os43.qcow2”) hat kein Raw-Format – daran scheitert u.a. “kpartx -a”.

- In dem Container-File befindet sich eine Partition, mittels derer das Gastsystem eine LVM-Logical-Volume-Group “lvg1” samt einem Logical Volume “lvroot” angelegt hat.

Zum ersten Problem:

Es ist hier zu bedenken, dass wir das zu prüfende Filesystem ja nicht auf dem Host mounten wollen. Das einzige mir bekannte Programm, das uns den Inhalt (also die Partitionen) des qcow2-Files samt Offsets bedarfsgerecht zur Verfügung stellt, ist <strong>qemu-nbd</strong>. Bedarfsgerecht heißt hier, dass Physical Volumes (Partitione) des Gastes anschließend auf dem KVM-Host in Form von Loop-Devices weiter genutzt werden können. Das ermöglicht es uns dann, die LVM Volume-Group und die LVM-Volumes innerhalb des qcow2-Files anzusprechen und “fsck -f” auszuführen.

Hinweis:

Es gibt zwar eine Möglichkeit eine Standardvariante von fsck innerhalb des Kommandos “guestfish” aus der libguestfs-Suite anzuwenden (s.u.); “fsck -f” geht damit aber nicht.

Zum zweiten Problem:

Neben der Aufdröselung der Partitionsstruktur (samt Offsets) im qcow2-File mit seinem komplexen Format, müssen geeignete Tools auf dem Host auch noch die interne LVM-Struktur erkennen und zu aktivieren. Wir werden hierfür das Gespann “vgscan und “vgchange” einsetzen.

Entschlüsselung und Mounten des LVM-Volumes des Hosts

Alle nachfolgenden Kommandos werden wieder direkt auf dem KVM-Host ausgeführt. Zunächst müssen wir wie in Variante 1 das passende LVM-Volume des KVM-Hosts entschlüsseln. Wir müssen das dekryptierte Device anschließend aber auch noch an geeigneter Stelle des Hosts mounten, um das dort enthaltene Disk-Image-File ansprechen zu können:

mxtux:~ # cryptsetup open /dev/mapper/volssd10-kvmos cr_kvmos Enter passphrase for /dev/mapper/volssd10-kvmos: mxtux:~ # mxtux:~ # la /dev/mapper total 0 drwxr-xr-x 2 root root 420 Aug 6 11:52 . drwxr-xr-x 27 root root 12300 Aug 6 11:52 .. crw------- 1 root root 10, 236 Aug 6 08:49 control lrwxrwxrwx 1 root root 8 Aug 6 11:48 cr_kvmos -> ../dm-16 ... lrwxrwxrwx 1 root root 7 Aug 6 11:48 volssd10-kvmos -> ../dm-6 ... mxtux:~ # mount /dev/mapper/cr_kvmos /kvm/os mxtux:~ #

Informationen zum Partitionsaufbau innerhalb des qcow2-Image-Files:

Während kpartx keine ausreichenden Informationen liefert, ermöglicht uns das Kommando “virt-filesystems” aus der libguestfs-Suite (bei Bedarf installieren!) einen Einblick in die Unterteilung des qcow2-Image-Files “os43.qcow2”:

mytux:~ # virt-filesystems -a /kvm/os/os43.qcow2 --extra -l Name Type VFS Label Size Parent /dev/sda1 filesystem swap - 2153775104 - /dev/lvg1/lvroot filesystem ext4 - 8589934592 -

Netterweise erkennt “virt-filesystems” sogar die LVM-Volume-Group “lvg1” und das Volume “lvroot” ! Wir könnten dieses logische Volume des Gastes nun sogar mittels des Kommandos “guestmount” (ebenfalls Teil der libguestfs) auf dem Host mounten und mit den Inhalten arbeiten:

mytux:~ # guestmount -a /kvm/os/os43.qcow2 -m /dev/lvg1/lvroot --ro /mnt2 mytux:~ # la /mnt2 total 136 drwxr-xr-x 23 root root 4096 Jun 7 18:27 . drwxr-xr-x 40 root root 4096 Jul 25 18:55 .. drwxr-xr-x 2 root root 4096 May 14 19:20 bin drwxr-xr-x 3 root root 4096 May 14 19:22 boot drwxr-xr-x 2 root root 4096 May 14 17:09 dev drwxr-xr-x 128 root root 12288 Aug 4 11:41 etc drwxr-xr-x 3 rmu users 4096 May 28 17:43 extras drwxr-xr-x 4 root root 4096 May 15 20:29 home drwxr-xr-x 12 root root 4096 May 14 19:20 lib drwxr-xr-x 7 root root 12288 May 14 19:21 lib64 drwx------ 2 root root 16384 May 14 17:09 lost+found drwxr-xr-x 2 root root 4096 May 10 2017 mnt drwxr-xr-x 2 root root 4096 May 10 2017 opt drwxr-xr-x 2 root root 4096 May 14 17:09 proc drwx------ 9 root root 4096 Jun 12 21:52 root drwxr-xr-x 2 root root 4096 May 14 17:09 run drwxr-xr-x 2 root root 12288 May 14 21:12 sbin drwxr-xr-x 2 root root 4096 May 10 2017 selinux drwxr-xr-x 5 root root 4096 May 14 17:12 srv drwxr-xr-x 2 root root 4096 May 14 17:09 sys drwxrwxrwt 26 root root 12288 Aug 4 11:41 tmp drwxr-xr-x 13 root root 4096 May 14 17:10 usr drwxr-xr-x 12 root root 4096 May 14 17:24 var mytux:~ # umount /mnt2

Leider bringt uns das hinsichtlich des angestrebten “fsck” aber gar nichts.

nEinsatz von “qemu-nbd”

Im Gegensatz zu RAW-Devices oder Raw-Image-Files kommen wir an dieser Stelle nicht um den Einsatz von des qemu-eigenen Kommandos “qemu-nbd” herum. Also:

mxtux:~ # modprobe nbd max_part=8 mxtux:~ # qemu-nbd --connect=/dev/nbd0 /kvm/os/os43.qcow2 mxtux:~ # la /dev/ | grep nbd0 brw-rw---- 1 root disk 43, 0 Aug 6 16:22 nbd0 brw-rw---- 1 root disk 43, 1 Aug 6 16:22 nbd0p1 brw-rw---- 1 root disk 43, 2 Aug 6 16:22 nbd0p2

Was verbirgt sich hinter diesen neuen Devices dahinter?

mxtux:~ # fdisk -l /dev/nbd0 Disk /dev/nbd0: 15 GiB, 16106127360 bytes, 31457280 sectors Units: sectors of 1 * 512 = 512 bytes Sector size (logical/physical): 512 bytes / 512 bytes I/O size (minimum/optimal): 512 bytes / 512 bytes Disklabel type: dos Disk identifier: 0x000392a8 Device Boot Start End Sectors Size Id Type /dev/nbd0p1 2048 4208639 4206592 2G 82 Linux swap / Solaris /dev/nbd0p2 * 4208640 31457279 27248640 13G 8e Linux LVM

Aha, fdisk erkennt, dass die zweite Partition LVM nutzt. Wie kommen wir nun weiter? “kpartx” führt uns nicht zum Ziel, da LVM Volume Groups erst aktiviert werden müssen. Hierzu sind zwei Schritte nötig

- Schritt 1: Wir müssen uns das LVM-Device des qcow2-Files auf dem Host zugänglich machen – als Loop-Device. Dazu berechnen wir dessen Offset ( = 4208640 * 512 = 2154823680)

- Schritt 2: Wir müssen wir auf dem KVM-Host das Kommando “vgscan” ausführen und danach die gewünschten Volume Group mit “vgchange” aktivieren

Also:

mxtux:~ # vgscan Reading all physical volumes. This may take a while... Found volume group "volssd10" using metadata type lvm2 Found volume group "lvgssd5" using metadata type lvm2 Found volume group "lvg2" using metadata type lvm2 Found volume group "lvg10f2" using metadata type lvm2 Found volume group "volgrp1" using metadata type lvm2 mxtux:~ # losetup -o 2154823680 /dev/loop5 /dev/nbd0 mxtux:~ # vgscan Reading all physical volumes. This may take a while... Found volume group "lvg1" using metadata type lvm2 Found volume group "volssd10" using metadata type lvm2 Found volume group "lvgssd5" using metadata type lvm2 Found volume group "lvg2" using metadata type lvm2 Found volume group "lvg10f2" using metadata type lvm2 Found volume group "volgrp1" using metadata type lvm2 mxtux:~ #

Aha, vgscan erkennt eine neue Volume-Group “lvg1”. Wir sehen hier übrigens, dass es sich lohnt, die Bezeichnungen von Groups auf dem Host und den Gastsystemen unterschiedlich und global eindeutig zu wählen – etwas, das ich hier zu meiner Schande versäumt habe. Nun müssen wir die Volume Group noch aktivieren:

mxtux:~ # vgchange -ay lvg1 1 logical volume(s) in volume group "lvg1" now active mxtux:~ # mxtux:~ # la /dev/mapper total 0 drwxr-xr-x 2 root root 460 Aug 6 16:44 . drwxr-xr-x 28 root root 12880 Aug 6 16:44 .. crw------- 1 root root 10, 236 Aug 6 08:49 control lrwxrwxrwx 1 root root 8 Aug 6 11:48 cr_kvmos -> ../dm-16 ... lrwxrwxrwx 1 root root 8 Aug 6 16:44 lvg1-lvroot -> ../dm-19 ... lrwxrwxrwx 1 root root 8 Aug 6 16:33 nbd0p2p1 -> ../dm-18 ... mxtux:~ # fdisk -l /dev/mapper/lvg1-lvroot Disk /dev/mapper/lvg1-lvroot: 8 GiB, 8589934592 bytes, 16777216 sectors Units: sectors of 1 * 512 = 512 bytes Sector size (logical/physical): 512 bytes / 512 bytes I/O size (minimum/optimal): 512 bytes / 512 bytes mxtux:~ # virt-filesystems -a /dev/nbd0 --extra --parts --blkdevs --filesystems -l --lvs Name Type VFS Label MBR Size Parent /dev/sda1 filesystem swap - - 2153775104 - /dev/lvg1/lvroot filesystem ext4 - - 8589934592 - /dev/lvg1/lvroot lv - - - 8589934592 /dev/lvg1 /dev/sda1 partition - - 82 2153775104 /dev/sda /dev/sda2 partition - - 8e 13951303680 /dev/sda /dev/sda device - - - 16106127360 -

Nun können wir den Filesystem-Check des LVM-Volume des KVM-Gasts, das sich m qcow2-File befindet, auf dem KVM-Host ausführen. Und danach alle Kommandos wieder rückgängig machen:

mxtux:~ # fsck -f /dev/mapper/lvg1-lvroot fsck from util-linux 2.29.2 e2fsck 1.42.11 (09-Jul-2014) Pass 1: Checking inodes, blocks, and sizes Pass 2: Checking directory structure Pass 3: Checking directory connectivity Pass 4: Checking reference counts Pass 5: Checking group summary information /dev/mapper/lvg1-lvroot: 245825/524288 files (0.1% non-contiguous), 1707336/2097152 blocks mxtux:~ # mxtux:~ # vgchange -an lvg1 0 logical volume(s) in volume group "lvg1" now active rux:~ # la /dev/mapper total 0 drwxr-xr-x 2 root root 440 Aug 6 17:09 . drwxr-xr-x 27 root root 12840 Aug 6 17:09 .. crw------- 1 root root 10, 236 Aug 6 08:49 control lrwxrwxrwx 1 root root 8 Aug 6 11:48 cr_kvmos -> ../dm-16 ... lrwxrwxrwx 1 root root 8 Aug 6 16:33 nbd0p2p1 -> ../dm-18 .. mxtux:~ # losetup -d /dev/loop5 mxtux:~ # qemu-nbd -d /dev/nbd0 /dev/nbd0 disconnected mxtux:~ # rmmod nbd mxtux:~ #

Ich bitte zu beachten, dass wir in diesem Fall trotz der bereits sehr komplexen Schichtung immer noch einen Vorteil hatten: Es gab nur genau ein virtuelles LVM-Physical-Volume des Gast-Systems, nämlich die zweite Partition innerhalb des qcow2-Files. Ferner gabe es nur eine Volume-Group. Bei mehreren “Volume Groups”, die sich über unetrschiedliche “Physical Volumes” aus verschiedenen virtuellen Partitionen des Gastes erstreckten, hätten wir alle zugehörigen virtuellen Partitionen auf dem Host als Loop-Devices bereitstellen müssen. Das ist uns im Beipiel erspart geblieben.

fsck in einer dritten Variante – verschlüsseltes LVM-Volume mit einem RAW Image File

Nach all dem Zirkus mit qcow2 stellt sich die Frage: Warum verwendet man nicht gleich Image-Files im Raw-Format? Das ist ein gute Frage; ich werde die Antwort aber auf einen anderen Artikel verschieben. Genannt sei nur der Vorteil des langsam auf die Maximalgröße wachsenden Platzbedarfs im Falle qcow2. Für Disk-Image-Files im Raw-Format spricht aber die Performance. Dennoch ein lapidarer Hinweise zum Einsatz von “fsck” für Partitionen in Raw-Container-Files:

Dieser Fall kann im Kern fast genauso behandelt werden kann, wie oben unter Variante 1 beschrieben. Wer so etwas testen will, kann ja mal ein qcow2-File in ein Raw-Format-File mittels des Kommandos “qemu-img convert” umwandeln (s. die entsprechende man -Seite).

Fazit und eine Alternative

“fsck” mit zugehörigen Optionen für Filesysteme anzuwenden, die sich in verschlüsselten LVM-Volumes eines KVM-Hosts befinden, ist relativ einfach, wenn das LVM-Volume dem KVM-Gast entweder direkt als Raw-Device zur Verfügung gestellt wird oder aber über ein Disk-Image-File im RAW-Format, das sich auf dem Volume befindet. Befinden sich dann unter dem Raw-Device nur gewöhnliche Partitionen kann man sich das Leben mit “kpartx” bequem machen.

Deutlich schwieriger wird die Sache aber mit qcow2-Imag-Files und/oder virtuellen Partitionen von Image-Files, die auf dem Gastsystem in dortigen LVM-Volume-Groups eingesetzt werden. Im Falle von qcow2-Files muss man zunächst zwingend das Kernel-Modul “nbd” und den “qemu-nbd”-Befehl einsetzen.

LVM-Groups innerhalb vom Image-Disk-Files verlangen ferner die Bereitstellung aller entsprechenden zugehörigen virtuellen “Physical Volumes” (virtuelle Partitionen) als Loop-Devices auf dem KVM-Host. Danach sind die Befehle “vgscan” und “vgchange” anzuwenden, um schließlich unter “/dev/mapper” das logische Volume des Gastes mit seinem Filesystem zu erhalten. Erst dann kann man hierauf “fsck” anwenden. Das ist schon komplex, aber man hat am Ende die volle Kontrolle über fsck.

Wem das alles zu schwierig ist, der kann alternativ mal eine einfache Standardvariante des fsck-Befehls unter “guestfish” für Filesysteme von KVM-Gästen ausprobieren. Funktioniert für Raw-Devices und qcow2-Files!