Nach einem früheren Beitrag zu KDE 4 möchte ich nun nach ca. 1 Monat produktiver Arbeit unter dieser Oberfläche eine Reihe von Einschränkungen bzgl. des Einsatzes in einem produktiven Umfeld machen. Ich schicke voraus, dass ich KDE 4.1.3 unter Opensuse 11.0 verwende. Das System wird bzgl. KDE 4 auf sehr aktuellem Stand gehalten. Als Graphikkarte kommt einen Nvidia-Karte zum Einsatz. Ich möchte auch betonen, dass ich vorher mit KDE 3.5.10 sehr zufrieden war.

Problembereich Konqueror

Konqueror unter KDE 4 erscheint mir in vielerlei Hinsicht unausgereift. Die nervigsten Punkte, die ein produktives Arbeiten verhindern, sind:

- Regelmäßige Abstürze bei Multimedia-lastigen Seiten (u.a. mit Flash-Elementen, man gehe nur mal auf die Nvidia-Seiten oder die Seiten der Telekom oder von Vodafone und probiere dort alle Optionen aus),

- Falsche Behandlung und Darstellung von Seiten mit halb-opaquen Designelementen (wie halbtransparenten Menüpunkten); die Darstellung ist z.T. katastrophal bei dynamischen halbtransparenten Objekten. Man sollte solche Elemente lieber noch eine Weile völlig intransparent darstellen als den experimentellen Murks anzubieten, der im Moment vorhanden ist.

- Fehler oder Unsauberkeiten in der Javascript-Engine – im Besonderen bei Querbeziehungen zwischen mehreren geöffneten Fenstern einer Applikation (so kann man PhpMyAdmin z.B. wegen dieser Probleme nicht in vollem Umfang benutzen – wahnsinnig nervig)

- Eine falsche und z.T. chaotische Behandlung von “textarea”-Elementen auf Formularseiten im Zusammenhang mit Mausinteraktionen (falsche Cursordarstellung bei scrollbaren Feldern über dem Scrollbar, falsches Einsprungverhalten bei Maus-Klick auf den Text – vermutlich wg. Fehlberechnung der Scrollposition, etc.) Das macht den Einsatz im Zusammenhang mit formularlastigen Datenbankapplikationen zur Nervensache ….)

- Falsche Breitenberechnung von Input-Elementen bei der Inhaltsdarstellung – zuminest bei verwendung des Oxygen-Designs für die KDE-Oberfläche – auch dies wieder nervig bei formularlastigen Web-Applikationen

All diese Schwierigkeiten tauchen in anderen Browsern (Firefox, Opera) nicht oder nicht in dem Ausmaß auf wie in KDE4’s Konqueror.

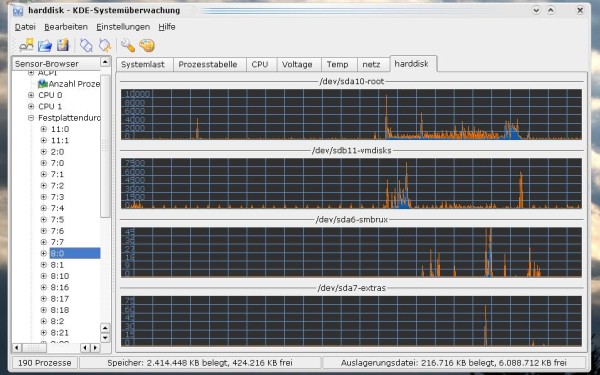

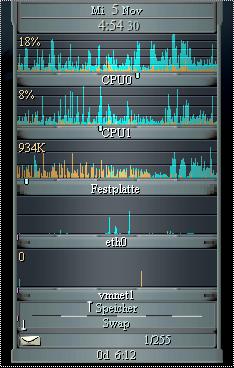

Problembereich CPU-Belastung

Generell erscheint mir die CPU-Belastung im Schnitt deutlich höher zu sein als unter KDE 3.5.10.

Ich muss aber dazu sagen, dass ich Compiz im Einsatz habe und hier spielen evtl. auch die Nvidia-Treiber eine Rolle. Auffällig ist z.B., dass aktive, geöffnete Amarok-Fenster zu einem Anstieg der CPU-Belastung von über 10% führen im Gegensatz zu einer Situation, in der das Amarok-Fenster minimiert ist. Die laufenden Bildschirmupdates kosten unter KDE4 scheinbar erhebliche CPU-Zeit.

Dieses Problem gab es früher auch schon mal unter KDE 3.5, war dann aber eine ganze Weile beseitigt.

Aber auch Applikationen wie das neue Ksysguard sind wahre Ressourcenfresser – reale Messungen der CPU-Belastung sind damit fast nicht mehr möglich, weil Ksysguard oft selbst mehr Ressourcen als andere Applikationen schluckt.

Problembereich GTK-basierte Applikationen (Openoffice, VMware Wokstation, etc. )

Es ist wirklich nervig, dass das Arbeiten in und mit GTK-Applikationen zu störenden Nebeneffekten auf der KDE4-Oberfläche führt – u.a. Überdeckung der KDE4 Kontroll-Leiste durch Artefakte. Diese verschwinden wieder, wenn man die Maus in den gestörten Bildschirmbereich bewegt – ärgerlich ist das aber trotzdem. Zumal durch die Artefakte auch Bereiche überdeckt werden, die Informationen beinhalten.

Ob auch dies mit Nvidia-Treibern zusammenhängt konnte ich nicht prüfen; es hängt aber sicher nicht mit Compiz zusammen, sondern ist ein reines Problem zwischen der KDE-Oberfläche und GTK-

Applikationen. Das haben auch andere bestätigt.

Probleme mit Notizbüchern unter Kontact

Leider muss ich sagen, dass das Arbeiten mit Notizbüchern unter Kontact ein Glücksspiel ist. Mir sind bereits mehrfach Einträge verlorengegangen. Es fehlt eindeutig eine Option zum Zwischenspeichern eines erarbeiteten Eintrags. Notizbücher sind ein schönes Feature, aber leider noch viel zu unsicher für den produktiven Einsatz.

Als Anwender kann man nur hoffen, dass die Konqueror-Probleme und das generelle Problem mit GTK-Applikationen unter KDE 4 umgehend gelöst werden.